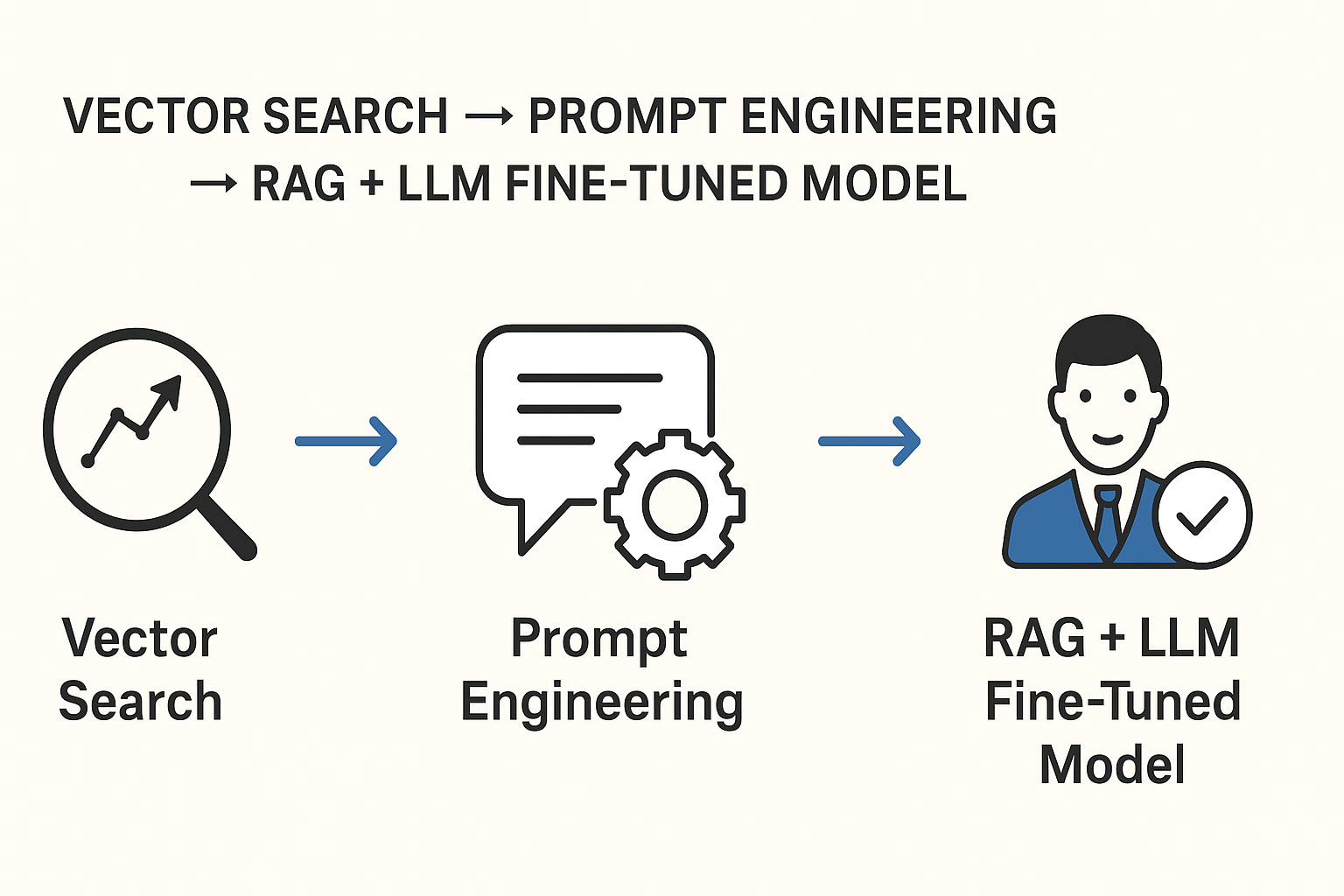

ビジネスにおける「ベクトル検索 → プロンプトエンジニアリング → RAG+LLMファインチューニングモデル」が最強となる理由と、従来型チャットボットとの違いを、ステップごとにわかりやすく解説します。

1. 従来のチャットボットとの違い

- 従来のルールベース/キーワードマッチング型

- 事前に用意したフロー図やキーワードに応じて固定応答

- 弱点:想定外の質問に弱く、メンテナンスコストが高い

- AI検索(ベクトル検索)チャットボット

- ユーザークエリをベクトル化し、ドキュメントの埋め込みベクトルと類似度でマッチング

- 強み:ナレッジベースにない言い回しでも柔軟に回答可能

- 弱点:そのまま類似文を返すだけで「言い回しの整形」や「要約」は弱い

- AIチャットボット+プロンプトエンジニアリング

- ベクトル検索で引き出した情報を、精緻化したプロンプトでLLMに投げ、要約・言い換え

- 強み:読みやすい自然言語で、かつ要点を絞った回答が得られる

- 弱点:まだ回答の一貫性や専門性は汎用LLMのまま

- RAG(Retrieval‑Augmented Generation)対応チャットボット

- ベクトル検索+プロンプトでの要約に加え、リアルタイムの外部ドキュメントも参照

- 強み:ナレッジが常に最新、ドメイン特化の正確性も向上

- 弱点:大規模なデータ管理・プライバシー対策コストがかかる

- ファインチューニング+RAG併用モデル

- 自社データで微調整したLLMをRAGと組み合わせ

- 強み:

- 専門ドメイン知識に最適化された“自社専用AI”

- 一貫性のあるトーン&スタイル

- 高い回答精度・省コストの運用

- 導入効果:FAQ応答、営業支援、社内ドキュメント検索から自動要約まで、オールインワンでサポート

2. なぜこの組み合わせが「最強」なのか?

- 柔軟性と汎用性

- ベクトル検索で未知の質問も広くカバー

- プロンプトエンジニアリングで「何を」「どう返すか」をコントロール

- 精度の向上

- RAGで最新情報にアクセス

- ファインチューニングでドメイン固有の言い回しや専門知識を強化

- コスト最適化

- 汎用LLM API呼び出しより、微調整モデル活用でトークンあたりコストを抑制

- 検索+生成のハイブリッドにより、不要なAPI呼び出しを削減

- ユーザー体験の大幅改善

- 一貫性のある回答、専門性の担保、最新情報の提示

- チャットからアクションへ自然につなげられる(例:フォーム入力、ワークフロー起動)

3. チャットボット段階レベル比較表

| レベル | 特徴 | 主なメリット | 主なデメリット | 想定コスト/月(日本市場) |

|---|---|---|---|---|

| 1. 従来のチャットボット | ルールベース/キーワードマッチ | 導入コスト低 | 対話の柔軟性×、メンテ高 | ¥50,000~¥100,000(初期開発+保守費用) |

| 2. AI検索チャットボット | ベクトル検索のみ | 柔軟な検索応答 | 自然言語整形なし | +API埋め込み費用※: 約¥10,000~¥30,000 |

| 3. AIチャットボット(プロンプトエンジニアリング) | 検索+プロンプト最適化 | 自然な文章生成 | モデルは汎用LLM | API費用: 約¥50,000~¥100,000(1Mトークン/月想定) |

| 4. RAG対応AIチャットボット | 検索+生成+外部データ参照 | 常に最新・高精度 | ストレージ/セキュリティ管理コスト増 | 上記+ストレージ費: 約¥20,000~¥50,000 |

| 5. ファインチューニング+RAG併用モデルのAIチャットボット | ドメイン特化LLM+検索+生成 | 専門性最高、一貫性担保、省コスト運用 | 微調整・運用体制構築コスト | 微調整費用: ¥200,000~¥500,000(初期) 運用: 約¥80,000~¥150,000 |

注)

- API費用はトークン単価 × 利用量で変動します。

- ストレージ費用はドキュメント量に依存します。

- ファインチューニングの初期費用はモデルサイズ・データ量で増減します。

まとめると、

- ステップを踏むごとに「回答の質」「柔軟性」「コスト効率」が大幅に向上

- 最終段階の「ファインチューニング+RAG」は、ビジネス要件に最適化された“専用AI”として、従来型の比ではないサポート力を発揮します。

- 投資対効果を最大化するには、自社データやユースケースに合わせた「段階的導入+プロンプト/モデル最適化」が鍵になります。

SyschooLMSのAICHATは、ユーザーの質問を、日本語理解度が高いLLMのChatGPTでベクトル化して検索。検索結果と専用プロンプトエンジニアリングを使い、さらに、導入企業専用にファインチューニングしたGoogleGeminiのLLMモデルを併用してRAGとしてのハイブリッド運用を行います。

この最高品質モデルを、極限まで削減した開発コストと、業界標準化による運用コスト低減により、低価格で提供します。

- 0 Comments

- AI検索

- RAG

- ファインチューニング

- プロンプト